Les avertissements les plus retentissants sur la superintelligence proviennent de ses développeurs. Pourtant, l’appel à une supervision mondiale ne se nourrit pas seulement de la peur. Il se situe dans le champ de tension entre les préoccupations de sécurité et la question du contrôle de l’infrastructure qui structurera à l’avenir le pouvoir économique et politique.

L’alarme contrôlée

L’avertissement concernant une possible super-IA remplit une fonction identifiable. Il déplace le débat de l’innovation vers la sécurité. Dès que l’intelligence artificielle est perçue comme une menace existentielle, la régulation apparaît inévitable. Lorsque, par exemple, le PDG d’OpenAI Sam Altman met en garde contre une superintelligence incontrôlable tout en appelant à une supervision internationale, il positionne son entreprise comme un acteur responsable et un interlocuteur incontournable pour les gouvernements. Il en résulte un avantage discursif. Une projection technologique devient une mise à l’agenda politique — et une question d’avenir devient une question politique du présent.

La régulation comme instrument de pouvoir

La discussion autour d’une autorité internationale de l’IA, souvent calquée sur l’agence de contrôle de l’énergie atomique, paraît à première vue plausible. Des normes de sécurité et des obligations de licence doivent limiter les risques et accroître la transparence. Mais la régulation n’est jamais neutre. Des exigences élevées créent des barrières à l’entrée élevées. Seules les entreprises disposant de ressources considérables peuvent assumer des structures de conformité complexes, une sécurité juridique et des investissements technologiques à long terme. Les acteurs plus modestes ou les initiatives de recherche ouvertes auraient bien plus de difficultés à satisfaire ces normes. Les entreprises bénéficiant déjà d’avantages d’échelle globaux pourraient transformer leur position en oligopole régulé. Sécurité et concentration du marché progresseraient alors de concert.

L’apocalypse spéculative

L’idée d’une superintelligence autonome apparaissant à court terme demeure hypothétique. Il n’existe aucun système doté d’une volonté stratégique propre, aucune architecture fiable pour une auto-amélioration illimitée et aucune base empirique indiquant que l’intelligence globale de l’humanité sera bientôt dépassée. Pourtant, ce scénario déploie un effet politique considérable. Il légitime des contrôles préventifs et des interventions étendues dans le développement technologique et la régulation. Un futur possible devient ainsi le fondement de décisions présentes. Dans le même temps, il serait réducteur de considérer la régulation uniquement comme un instrument de pouvoir. Les systèmes d’IA interviennent déjà dans les marchés financiers ainsi que dans les processus décisionnels militaires et administratifs. Les questions de responsabilité et d’abus sont réelles. La question décisive est donc moins de savoir si une régulation aura lieu que de déterminer dans quel cadre institutionnel elle s’inscrira.

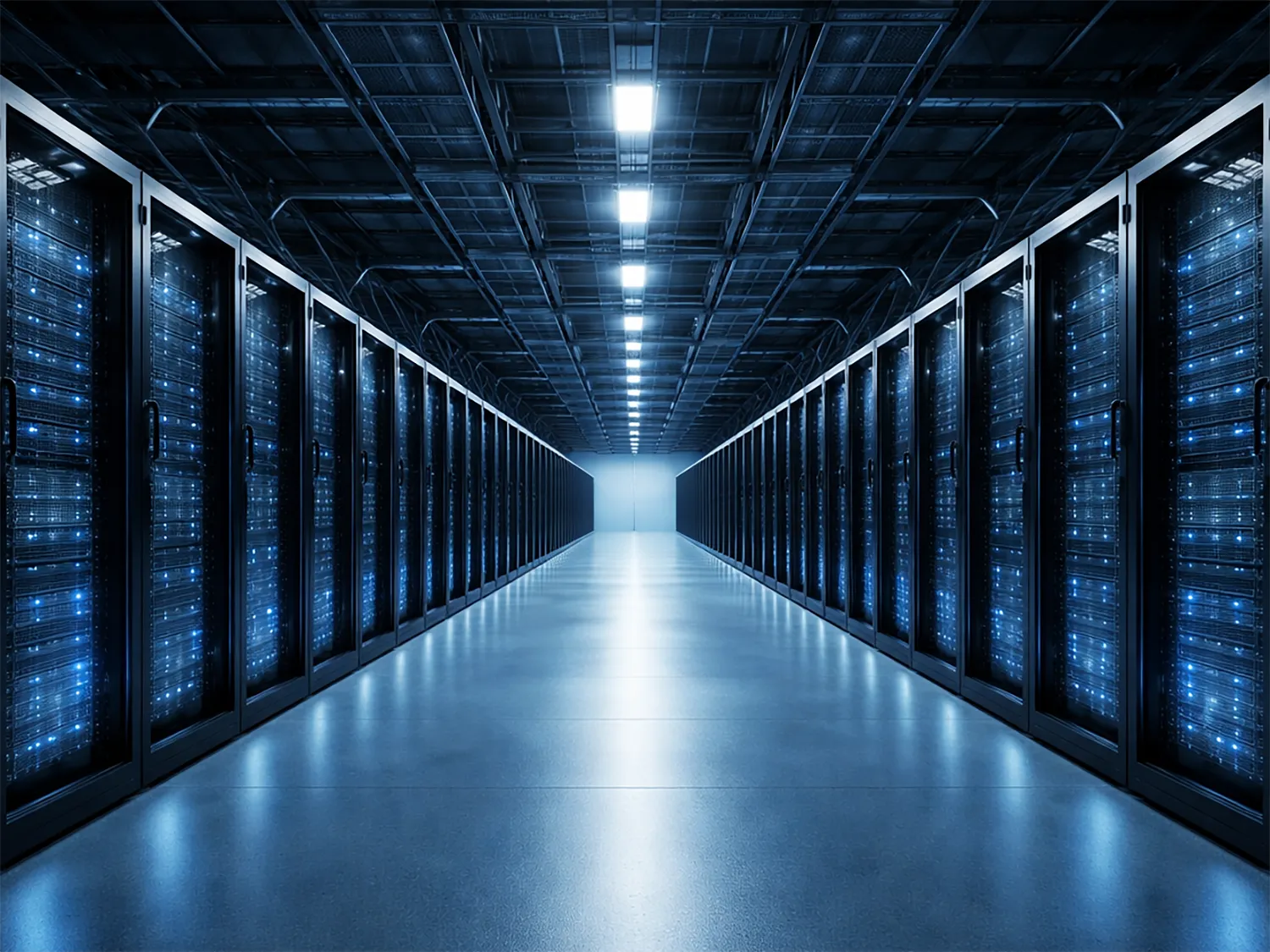

Infrastructure plutôt qu’intelligence

La transformation réelle réside moins dans une hypothétique apocalypse des machines que dans la concentration de la puissance de calcul. L’intelligence devient une infrastructure de base qui naît dans d’immenses centres de données et exige d’énormes investissements en énergie et en matériel. Seuls quelques acteurs disposent de ces ressources. Ceux qui contrôlent ces capacités déterminent l’accès au soutien décisionnel automatisé dans l’économie et l’État. La question du pouvoir se situe donc moins dans l’algorithme que dans la base matérielle de son calcul. L’IA devient ainsi une ressource stratégique comparable à l’énergie ou aux télécommunications. Le débat sur la superintelligence détourne toutefois souvent l’attention du véritable centre du pouvoir technologique : la disponibilité de la capacité de calcul et de l’énergie.

Le problème de la légitimation

Lorsque les développeurs définissent les risques tout en exploitant les systèmes correspondants, une tension structurelle apparaît. Une supervision étroitement liée à l’industrie pourrait accroître la sécurité tout en stabilisant les rapports de pouvoir existants. La régulation ne se contenterait alors pas de contrôler, elle légitimerait également. La question démocratique centrale est donc : qui contrôle les contrôleurs et devant quelle instance sont-ils responsables ? Sans une distance institutionnelle claire, l’architecture de sécurité risque de se transformer en une architecture durable du pouvoir.

Le nouveau contrat industriel

Ce déplacement marque le véritable conflit. Le débat sur la super-IA porte moins sur la conscience des machines que sur le pouvoir institutionnel. Un nouveau contrat industriel se dessine entre les États, les entreprises technologiques et le public concernant l’ordre des systèmes numériques. Ceux qui élaborent ce contrat ne fixent pas seulement des normes de sécurité, mais déterminent aussi les structures économiques et culturelles des décennies à venir. Ceux qui définissent les cadres institutionnels façonnent la marge de manœuvre des États, des entreprises et de la société — et avec elle l’architecture du pouvoir des décennies à venir.