Las advertencias más contundentes sobre la superinteligencia provienen de sus desarrolladores. Sin embargo, el llamado a una supervisión global no se alimenta únicamente del miedo. Se sitúa en el campo de tensión entre las preocupaciones de seguridad y la cuestión del control de la infraestructura que en el futuro estructurará el poder económico y político.

La alarma controlada

La advertencia sobre una posible super-IA cumple una función reconocible. Desplaza el debate de la innovación hacia la seguridad. En cuanto la inteligencia artificial se percibe como una amenaza existencial, la regulación parece inevitable. Cuando, por ejemplo, el director ejecutivo de OpenAI, Sam Altman, advierte sobre una superinteligencia incontrolable y al mismo tiempo exige supervisión internacional, posiciona a su empresa como un actor responsable y un interlocutor indispensable para los gobiernos. De ello surge una ventaja discursiva. Una proyección tecnológica se convierte en establecimiento de agenda política —y una cuestión del futuro en una cuestión política del presente.

La regulación como instrumento de poder

La discusión sobre una autoridad internacional de IA, a menudo inspirada en el organismo de control de la energía atómica, parece a primera vista plausible. Los estándares de seguridad y las obligaciones de licencia pretenden limitar los riesgos y garantizar mayor transparencia. Sin embargo, la regulación nunca es neutral. Requisitos elevados generan altas barreras de entrada. Solo las corporaciones con enormes recursos pueden sostener estructuras complejas de cumplimiento, protección jurídica e inversiones tecnológicas a largo plazo. Los proveedores más pequeños o las iniciativas de investigación abierta tendrían muchas más dificultades para cumplir estos estándares. Las empresas que ya disponen de ventajas de escala global podrían transformar su posición en un oligopolio regulado. Seguridad y concentración de mercado crecerían en paralelo.

La apocalipsis especulativa

La idea de una superinteligencia autónoma que surja a corto plazo sigue siendo hipotética. No existe ningún sistema con voluntad estratégica propia, ninguna arquitectura fiable para una auto-mejora ilimitada y ninguna base empírica que indique que la inteligencia total de la humanidad será superada pronto. Sin embargo, este escenario despliega un considerable efecto político. Legitima el control preventivo y amplias intervenciones en el desarrollo tecnológico y la regulación. Un posible futuro se convierte así en la base de decisiones presentes. Al mismo tiempo, sería reduccionista considerar la regulación exclusivamente como instrumento de poder. Los sistemas de IA ya intervienen en los mercados financieros y en los procesos de decisión militares y administrativos. Las cuestiones de responsabilidad y abuso son reales. Por ello, la cuestión decisiva no es tanto si se regulará, sino en qué marco institucional tendrá lugar.

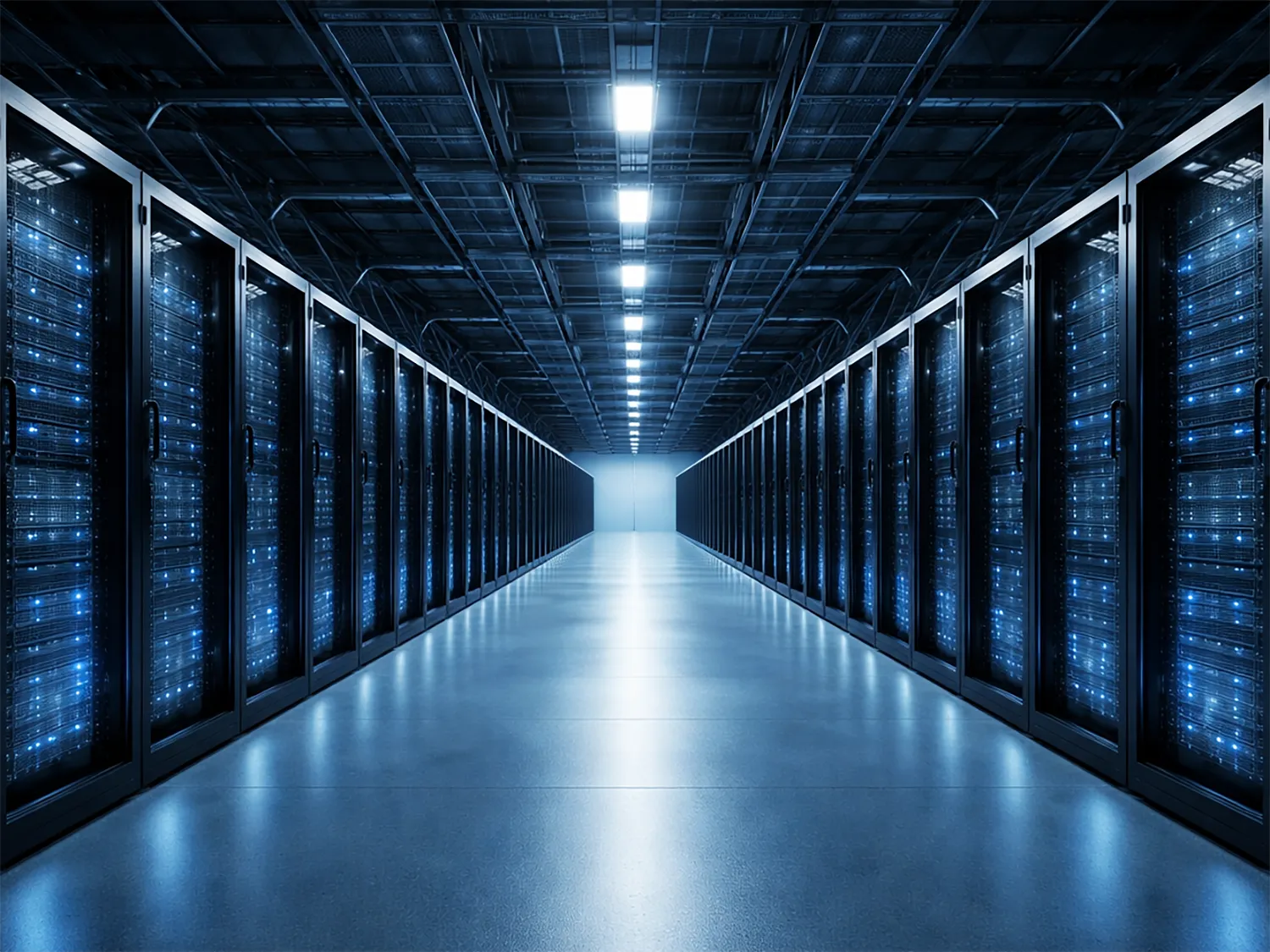

Infraestructura en lugar de inteligencia

La verdadera transformación reside menos en una hipotética apocalipsis de las máquinas que en la concentración de la capacidad de cómputo. La inteligencia se convierte en una infraestructura básica que surge en gigantescos centros de datos y requiere enormes inversiones en energía y hardware. Solo unos pocos actores disponen de estos recursos. Quien controla estas capacidades determina el acceso al apoyo automatizado a la toma de decisiones en la economía y el Estado. La cuestión del poder se sitúa, por tanto, menos en el algoritmo que en la base material de su cálculo. La IA se convierte así en un recurso estratégico comparable a la energía o las telecomunicaciones. Sin embargo, el debate sobre la superinteligencia a menudo desvía la atención del verdadero centro del poder tecnológico: la disponibilidad de capacidad de cómputo y de energía.

El problema de legitimación

Cuando los desarrolladores definen los riesgos y al mismo tiempo operan los sistemas correspondientes, surge una tensión estructural. Una supervisión estrechamente vinculada a la industria podría aumentar la seguridad y al mismo tiempo estabilizar las relaciones de poder existentes. La regulación no solo controlaría, sino que también legitimaría. La cuestión democrática central es, por tanto: ¿quién controla a los controladores y ante qué instancia deben rendir cuentas? Sin una clara distancia institucional, la arquitectura de seguridad corre el riesgo de convertirse en una arquitectura permanente de poder.

El nuevo contrato industrial

Este desplazamiento marca el conflicto real. El debate sobre la super-IA gira menos en torno a la conciencia de las máquinas que al poder institucional. Está surgiendo un nuevo contrato industrial entre los Estados, las empresas tecnológicas y el público sobre el orden de los sistemas digitales. Quien elabore este contrato no solo establecerá estándares de seguridad, sino que también determinará las estructuras económicas y culturales de las próximas décadas. Quien defina los marcos institucionales configurará el margen de acción de Estados, empresas y sociedad —y con ello la arquitectura de poder de las próximas décadas.