Die lautesten Warnungen vor Superintelligenz kommen von ihren Entwicklern. Doch der Ruf nach globaler Aufsicht speist sich nicht allein aus Furcht. Er bewegt sich im Spannungsfeld zwischen Sicherheitsbedenken und der Frage nach der Kontrolle jener Infrastruktur, die künftig wirtschaftliche und politische Macht strukturiert.

Der kontrollierte Alarm

Die Warnung vor einer möglichen Super-KI erfüllt eine erkennbare Funktion. Sie verschiebt die Debatte von Innovation zu Sicherheit. Sobald künstliche Intelligenz als existenzielle Bedrohung wahrgenommen wird, erscheint Regulierung als unvermeidlich. Wenn etwa OpenAI-CEO Sam Altman vor unkontrollierbarer Superintelligenz warnt und zugleich internationale Aufsicht fordert, positioniert er sein Unternehmen als verantwortlichen Akteur und unverzichtbaren Ansprechpartner für Regierungen. Damit entsteht ein diskursiver Vorteil. Aus einer technologischen Prognose wird politisches Agenda-Setting – und aus einer Zukunftsfrage eine politische Frage der Gegenwart.

Regulierung als Machtinstrument

Die Diskussion um eine internationale KI-Behörde, die oft an die Atomenergieaufsicht angelehnt ist, erscheint auf den ersten Blick plausibel. Sicherheitsstandards und Lizenzpflichten sollen Risiken begrenzen und für mehr Transparenz sorgen. Doch Regulierung ist nie neutral. Hohe Anforderungen erzeugen hohe Eintrittshürden. Nur Konzerne mit enormen Ressourcen können komplexe Compliance-Strukturen, juristische Absicherung und langfristige technologische Investitionen stemmen. Kleinere Anbieter oder offene Forschungsinitiativen hätten es erheblich schwerer, diese Standards zu erfüllen. Unternehmen, die bereits über globale Skalenvorteile verfügen, könnten ihre Stellung in ein reguliertes Oligopol überführen. Sicherheit und Marktkonzentration würden parallel wachsen.

Die spekulative Apokalypse

Die Vorstellung einer kurzfristig entstehenden, autonom handelnden Superintelligenz bleibt hypothetisch. Es gibt kein System mit eigenem strategischem Willen, keine belastbare Architektur für unbegrenzte Selbstverbesserung und keine empirische Grundlage dafür, dass die Gesamtintelligenz der Menschheit bald übertroffen wird. Dennoch entfaltet dieses Szenario eine erhebliche politische Wirkung. Es legitimiert präventive Kontrolle und weitreichende Eingriffe in die technologische Entwicklung und Regulierung. Eine mögliche Zukunft wird so zur Grundlage gegenwärtiger Entscheidungen. Gleichzeitig wäre es jedoch zu kurz gedacht, Regulierung ausschließlich als Machtinstrument zu betrachten. KI-Systeme greifen bereits in Finanzmärkte sowie militärische und administrative Entscheidungsprozesse ein. Fragen nach Haftung und Missbrauch sind real. Entscheidend ist daher weniger die Frage, ob reguliert wird, sondern in welchem institutionellen Rahmen dies geschieht.

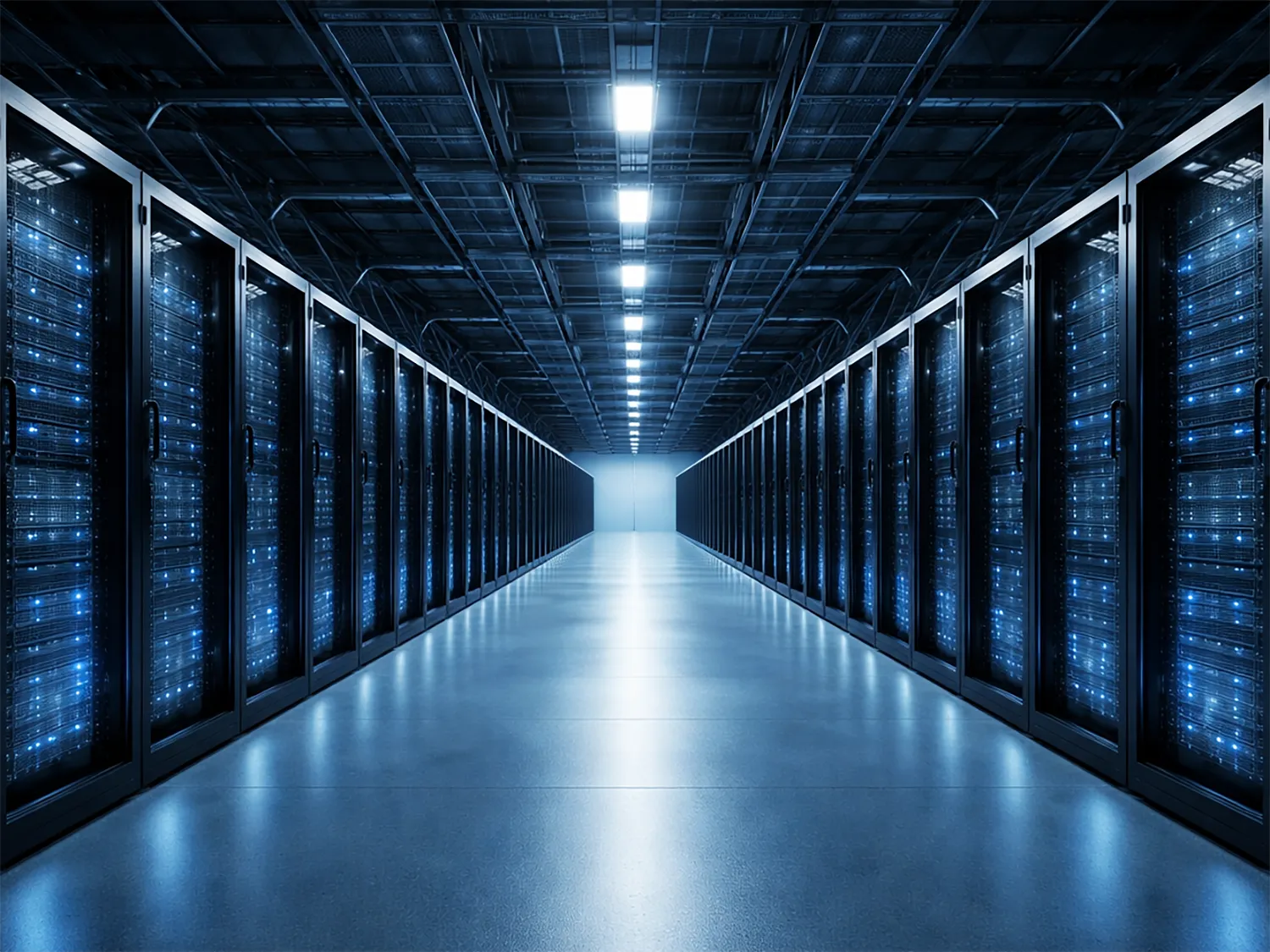

Infrastruktur statt Intelligenz

Die eigentliche Transformation liegt weniger in einer hypothetischen Maschinenapokalypse als in der Konzentration von Rechenleistung. Intelligenz wird zur Basisinfrastruktur, die in gigantischen Datenzentren entsteht und enorme Investitionen in Energie und Hardware erfordert. Nur wenige Akteure verfügen über diese Ressourcen. Wer diese Kapazitäten kontrolliert, bestimmt den Zugang zu maschineller Entscheidungsunterstützung in Wirtschaft und Staat. Die Machtfrage liegt daher weniger im Algorithmus als in der materiellen Grundlage seiner Berechnung. KI wird damit zu einer strategischen Ressource, die mit Energie oder Telekommunikation vergleichbar ist. Die Diskussion über Superintelligenz lenkt jedoch häufig vom eigentlichen Zentrum technologischer Macht ab, nämlich der Verfügbarkeit von Rechenkapazität und Energie.

Das Legitimationsproblem

Wenn Entwickler zugleich Risiken definieren und die entsprechenden Systeme betreiben, entsteht ein strukturelles Spannungsfeld. Eine eng mit der Industrie verflochtene Aufsicht könnte die Sicherheit erhöhen und gleichzeitig die bestehenden Machtverhältnisse stabilisieren. Regulierung würde dann nicht nur kontrollieren, sondern auch legitimieren. Die demokratische Kernfrage lautet daher: Wer kontrolliert die Kontrolleure und welcher Instanz sind sie rechenschaftspflichtig? Ohne klare institutionelle Distanz droht die Sicherheitsarchitektur zu einer dauerhaften Machtarchitektur zu werden.

Der neue Industrievertrag

Diese Verschiebung markiert den eigentlichen Konflikt. Die Debatte über Super-KI dreht sich weniger um Maschinenbewusstsein als um institutionelle Macht. Es entsteht ein neuer Industrievertrag zwischen Staaten, Technologieunternehmen und der Öffentlichkeit über die Ordnung digitaler Systeme. Wer diesen Vertrag ausarbeitet, legt nicht nur Sicherheitsstandards fest, sondern bestimmt auch die ökonomischen und kulturellen Strukturen der kommenden Jahrzehnte. Wer die institutionellen Rahmenbedingungen festlegt, prägt die Spielräume von Staaten, Unternehmen und Gesellschaft – und damit die Machtarchitektur der kommenden Jahrzehnte.